Revista Electrónica Educare (Educare Electronic Journal) EISSN: 1409-4258 Vol. 25(3) SETIEMBRE-DICIEMBRE, 2021: 1-21

doi: https://doi.org/10.15359/ree.25-3.2

http://www.una.ac.cr/educare

educare@una.ac.cr

[Cierre de edición el 01 de Setiembre del 2021]

Validación de prueba para evaluar la competencia digital en el área de resolución de problemas en estudiantes de educación obligatoria

Psycho-Technical Study of a Digital Competence Assessment Tool for Problem-Solving Skills of Compulsory Education Students

Validação de prova para avaliação de competência digital na área da resolução de problemas em estudantes de ensino obrigatório

Marcos Cabezas-González

Universidad de Salamanca

Salamanca, España

mcabezasgo@usal.es

https://orcid.org/0000-0002-3743-5839

https://orcid.org/0000-0002-3743-5839

Sonia Casillas-Martín

Universidad de Salamanca

Salamanca, España

scasillasma@usal.es

https://orcid.org/0000-0001-5304-524X

https://orcid.org/0000-0001-5304-524X

Ana García-Valcárcel-Muñoz-Repiso

Universidad de Salamanca

Salamanca, España

anagv@usal.es

https://orcid.org/0000-0003-0463-0192

https://orcid.org/0000-0003-0463-0192

Verónica Basilotta-Gómez-Pablos

Universidad a Distancia de Madrid

Madrid, España

veronicamagdalena.basilotta@udima.es

https://orcid.org/0000-0003-1976-4548

https://orcid.org/0000-0003-1976-4548

Recibido • Received • Recebido: 26 / 09 / 2019

Corregido • Revised • Revisado: 15 / 04 / 2021

Aceptado • Accepted • Aprovado: 26 / 05 / 2021

Resumen:

Introducción. La evaluación de la competencia digital del estudiantado es una actividad importante, ya que sus resultados aportarán información relevante para diseñar y desarrollar propuestas de alfabetización tecnológica dentro del sistema educativo. Para ello, es necesario diseñar procesos de evaluación que superen la percepción que los sujetos tienen de sí mismos en relación con diferentes aspectos de la competencia digital, para identificar, realmente, los conocimientos, capacidades y actitudes que poseen. Metodología. Este artículo presenta los resultados de un estudio cuyo objetivo es analizar las características psicométricas de una prueba para evaluar la competencia digital de estudiantes de educación obligatoria en el área competencial de resolución de problemas. El diseño metodológico es descriptivo y transversal y se ha utilizado una muestra de 595 estudiantes de 12-14 años de 17 centros educativos. Análisis de datos. Se centró en conocer la validez y fiabilidad del instrumento. Resultados y conclusión. Los resultados obtenidos llevan a concluir que estamos ante un instrumento válido y fiable que permite identificar el nivel de competencia digital observada en el área mencionada.

Palabras claves: Estudiantes de educación obligatoria; evaluación de competencias; competencia digital; resolución de problemas digitales.

Abstract:

Introduction. The assessment of students’ digital competence is essential as its results provide significant data to design and develop proposals for digital literacy instruments in the education system. Therefore, it is necessary to develop assessment procedures for individuals to overcome their self-limiting beliefs on digital competence and identify their knowledge, skills, and attitudes. Method. This article presents the results of a study aimed to analyze the psychometric characteristics of a tool to assess the digital competence of Compulsory Education students in the problem-solving competence area. The results were obtained by a descriptive and transversal methodology and a sample composed of 595 students aged 12-14 from 17 educational centers. The data analysis focused on the validity and reliability of the instrument. Results and conclusion. The main conclusion is that we are faced with an efficient and reliable tool that allows us to identify the level of observed digital competence in the area mentioned above.

Keywords: Compulsory education students; competency assessment; digital competence; digital problem-solving.

Resumo

Introdução. A avaliação das competências digitais para estudantes é uma atividade importante, posto que os seus resultados se constituem como informação relevante para a planificação e desenvolvimento de propostas de alfabetização tecnológica dentro do sistema educativo. Para tal, é necessário delinear processos de avaliação que superem a percepção que os sujeitos têm de si mesmos, relacionados a diferentes aspetos das suas competências digitais, para identificar, verdadeiramente, os conhecimentos, capacidades e atitudes que possuem neste domínio. Metodologia. Este artigo apresenta os resultados de um estudo cujo objetivo foi analisar as características psicométricas de uma prova para avaliar a competência digital dos estudantes do Ensino Obrigatório na área da resolução de problemas. O desenho metodológico é descritivo e transversal, tendo sido utilizada uma amostra de 595 estudantes entre os 12 e os 14 anos de idade, de 17 centros educativos. A análise dos dados centrou-se na validade e fiabilidade do instrumento. Resultados e conclusão. Os resultados obtidos permitem-nos concluir que estamos perante um instrumento válido e fiável, que ajuda na identificação de competência digital observada na área mencionada.

Palavras chave: Estudantes de escolaridade obrigatória; avaliação de competências; competências digitais; resolução de problemas digitais.

Introducción

En este artículo se presenta una parte del trabajo de un proyecto de investigación I+D denominado Evaluación de la competencia digital de los estudiantes de educación obligatoria y estudio de la incidencia de variables sociofamiliares, realizado por el Grupo de Investigación Innovación en Tecnología Educativa de la Universidad de Salamanca (GITE-USAL) y financiado por el Ministerio de Economía y Competitividad dentro del Programa Estatal de Fomento de la Investigación Científica y Técnica de Excelencia, del gobierno de España (EVADISO, EDU2015-67975-C3-3-P, MINECO/FEDER), cuya finalidad es evaluar la competencia digital de estudiantes de educación obligatoria.

El objetivo que se pretende conseguir es analizar las características psicométricas de una prueba para evaluar la competencia digital de estudiantes de educación obligatoria en el área competencial de resolución de problemas.

El manuscrito se estructura en cuatro apartados. El marco teórico que fundamenta la investigación, la descripción de la metodología empleada, los resultados obtenidos, y las conclusiones y discusión de estos.

Marco teórico

Vivimos en un mundo en el que la ciudadanía necesita de un conocimiento y de una accesibilidad tecnológica del mundo digital para convertirse en ciudadanos y ciudadanas digitales, por lo que el desarrollo de competencias digitales del estudiantado es uno de los objetivos de la educación del siglo XXI (Serafín et al., 2019).

La competencia digital alude a una realidad conceptualizada desde una heterogeneidad de términos: competencia digital, alfabetización digital, alfabetización mediática, entre otros (Alonso Ferreiro y Gewerc, 2018). Hay autores que utilizan el de alfabetización digital, mientras que otros prefieren el de competencia digital. No obstante, según Calvani et al. (2008), ambos términos se usan a menudo como sinónimos porque, en mayor o menor medida, se superponen.

El interés creciente por la evaluación y la certificación de la competencia digital ha originado, a lo largo de los años, diferentes modelos de estándares e indicadores que definen la competencia digital de la ciudadanía, personal docente y el estudiantado: Technological pedagogical content knowledge (TPACK) (Mishra y Koehler, 2006), National educational technology standars for teachers (ISTE, 2008), modelo Krumsvik (Krumsvik, 2011), UNESCO ICT competency framework for teachers (United Nations Educational, Scientific and Cultural Organization [UNESCO], 2011), ISTE Standards for Students: A Practical Guide for Learning with Technology (Brooks-Young, 2016), entre otros. En esta investigación se ha seguido uno de los referentes para el desarrollo de competencias digitales en Europa, el Marco Europeo de Competencia Digital (DigComp).

En el año 2013, la Comisión Europea dio a conocer el Marco para el desarrollo y la comprensión de la competencia digital en Europa (DigComp 1.0) (Ferrari, 2013). En 2016, fue actualizado por el Marco Europeo para la Competencia Digital de los Ciudadanos (DigComp 2.0) (Vuorikari et al., 2016) y en 2017 se produjo la última revisión y se publicó DigComp 2.1 (Carretero et al., 2017).

El modelo utilizado para realizar el estudio presentado en este artículo fue el DigComp 1.0, en el que se define la competencia digital como: Un conjunto de conocimientos, habilidades, actitudes, estrategias y valores que son puestos en acción cuando usamos las tecnologías y los medios digitales para realizar tareas, resolver problemas, comunicarse, tratar información, colaborar, crear y compartir contenidos y crear conocimiento, de forma efectiva, eficiente, apropiada, crítica, creativa, autónoma, flexible, ética y reflexiva para el trabajo, el ocio, la participación, el aprendizaje, la socialización, el consumo y el empoderamiento (Ferrari, 2013).

Este referente estructura la competencia digital en cinco áreas competenciales: (1) información, (2) comunicación, (3) creación de contenidos, (4) seguridad y (5) resolución de problemas; que agrupan veintiuna capacidades, organizadas en tres niveles (básico, intermedio y avanzado). Este artículo se centra en el área de resolución de problemas en la que se debe: identificar necesidades de uso de recursos digitales, tomar decisiones informadas sobre las herramientas digitales más apropiadas según el propósito o la necesidad, resolver problemas conceptuales a través de medios digitales, usar las tecnologías de forma creativa, resolver problemas técnicos, actualizar la propia competencia y la de otros (Ferrari, 2013); cuyas competencias son las de: (1) resolución de problemas técnicos, (2) identificación de necesidades y respuestas tecnológicas, (3) innovación y uso de la tecnología de forma creativa, (4) identificación de lagunas en la competencia digital (Ferrari, 2013).

La evaluación de competencias es “un procedimiento en el que se requiere que el estudiante complete tareas o procesos en los que se demuestre su habilidad para aplicar conocimiento y destrezas o aplicar conocimientos en situaciones simuladas similares a la vida real” (Castro Morera, 2011, p. 118). A la hora de evaluar la competencia digital, podría establecerse una clara diferenciación entre distintos tipos de investigaciones, teniendo en cuenta los instrumentos utilizados para valorarla: Las que se centran en la autovaloración del sujeto evaluado. Estas analizan la percepción que los individuos tienen de sí mismos en relación con diferentes aspectos de la competencia digital (véase, por ejemplo: Cabezas-González y Casillas-Martín, 2018). Y las centradas en desarrollar procesos de evaluación. En este caso, las investigaciones realizan evaluaciones, propiamente dichas, del nivel de competencia digital (véase, por ejemplo: Frailon et al., 2013). Las primeras presentan un claro sesgo centrado en el aspecto subjetivo de las respuestas de los sujetos participantes, lo que no permite determinar un nivel competencial objetivo. Las segundas suponen una manera más adecuada y fiable de medir, al tratarse de pruebas de medida directa.

Teniendo como base el Proyecto DigComp y en la línea de investigaciones que se centran en la validación de instrumentos para desarrollar procesos de evaluación de realización y observación, por medio de la ejecución de actividades o resolución de problemas (Casillas-Martín y Cabezas González, 2020; Casillas-Martín et al., 2020; García-Valcárcel Muñoz-Repiso et al., 2020), en este artículo presentamos el estudio psicométrico de una prueba para evaluar la competencia digital de estudiantes de educación obligatoria, en el área competencial de resolución de problemas.

Metodología

El diseño del estudio es descriptivo y transversal, ya que la información fue recogida en un único momento, durante el curso escolar 2018-2019.

Objetivo

Analizar las características psicométricas de una prueba para evaluar la competencia digital de estudiantes de educación obligatoria en el área competencial de resolución de problemas, incidiendo en su fiabilidad y validez.

Participantes

La evaluación se llevó a cabo en dos provincias de la Comunidad Autónoma de Castilla y León (España). Se utilizó un tipo de muestreo aleatorio estratificado, con un margen de error de +4%, para un nivel de confianza del 95%, lo que llevó a trabajar con 595 estudiantes de 12-14 años, de 17 centros educativos, de los cuales un 51,4% son mujeres y un 48,6% hombres.

Procedimiento y aplicación de la prueba

Para diseñar la prueba de evaluación, el trabajo del equipo investigador se organizó en tres fases:

Fase 1. Revisión documental

Se trata de una técnica que consiste en seleccionar y recopilar información por medio de la lectura y la crítica de recursos documentales y bibliográficos (Baena Paz, 1985).

En esta fase, se realizó una revisión documental sobre las dimensiones de la competencia digital, con la intención de formular un modelo de indicadores que sirviera de base para el diseño de la prueba de evaluación.

Fase 2. Elaboración de un modelo de indicadores de la competencia digital

Tras el análisis y la síntesis de la revisión documental, el equipo investigador adoptó el modelo DigComp 1.0 (Ferrari, 2013). Basándose en la estructura de este modelo, para el área de resolución de problemas fueron planteados un total de 56 indicadores adaptados a la población objeto de estudio, organizados en tres niveles (básico, intermedio y avanzado) y tres ámbitos (conocimiento, habilidad y actitud).

Estos indicadores pueden consultarse en el Modelo de indicadores para evaluar la competencia digital de los estudiantes tomando como referencia el modelo DigComp (INCODIES) (García-Valcárcel Muñoz-Repiso, Hernández Martín et al., 2019), documento más amplio en el que se recogen un total de 325 indicadores distribuidos entre las 5 áreas de la competencia digital.

Para la validación del contenido de los indicadores del área, se siguió el método de jueces. Un total de 18 personas expertas en el diseño de indicadores de evaluación, en competencia digital y profesionales en ejercicio de educación obligatoria, pertenecientes a diferentes ámbitos educativos (educación obligatoria, universidad, gestión educativa), evaluaron la importancia, pertinencia y claridad de los indicadores por medio de un cuestionario online con una escala tipo Likert de 4 grados (4-mucha, 3-bastante, 2-poca, 1-ninguna).

Fase 3. Diseño de la prueba de evaluación

A partir del modelo de indicadores, se procedió a elaborar un banco de ítems para el área de resolución de problemas. Esta batería de ítems se depuró por medio de una revisión de personas expertas, se diseñó la prueba de evaluación que fue aplicada a una muestra piloto de 288 estudiantes de educación obligatoria, calculándose los niveles de dificultad de los ítems de conocimiento y habilidad, así como la fiabilidad de los de actitud (α de Cronbach 0,78). Con los resultados obtenidos, se procedió a elaborar la prueba definitiva.

Esta prueba está compuesta por 16 ítems, 7 pertenecen al ámbito de conocimiento, 9 al de habilidad y 6 al de actitud. Las actitudes fueron valoradas con una escala Likert (1 muy en desacuerdo, 5 muy de acuerdo).

La aplicación de la prueba se realizó de modo online a través de una plataforma web diseñada con el propósito de facilitar las respuestas de escolares. En todo momento se contó con el permiso de las autoridades de la Administración Educativa y del Comité Ético de la Universidad de Salamanca.

Para proceder al desarrollo de la evaluación, fueron enviadas a los centros educativos seleccionados solicitudes de participación del estudiantado de sexto de educación primaria y primero de educación secundaria obligatoria. Todos los centros colaboraron voluntariamente para aplicar la prueba en horario lectivo y para encargarse de, a partir de protocolos específicos, recabar los permisos de las familias y de la niñez.

Análisis de los datos

Se centró en conocer la validez y fiabilidad del instrumento con la finalidad de comprobar sus características psicotécnicas. De manera que se realizó un análisis individual de cada uno de los ítems (varianza, correlación biserial-puntual, índice de dificultad, etc.) de conocimiento y capacidad y además de los que conformaban la escala de actitudes. Para obtener una visión general del instrumento, se llevó a cabo un estudio de la prueba completa y se analizó el posible sesgo en función del género.

Para los análisis se emplearon dos programas, el SPSS v.21 y el software CORRECTOR 1.2 desarrollado por el profesor Gaviria del Dpto. de Métodos de Investigación de la Universidad Complutense de Madrid. Este software actúa como un complemento de MS-Excel y permite analizar pruebas objetivas y de escalas tipo Likert, aportando información de cada ítem y del conjunto del instrumento.

Resultados

A continuación, se presentan los resultados teniendo en cuenta el objetivo planteado. Estos se organizan en tres apartados: análisis de los ítems de conocimiento y capacidad, análisis de los ítems de la escala de actitud, y análisis de la prueba completa.

Análisis de los ítems de conocimiento y capacidad

Análisis descriptivo

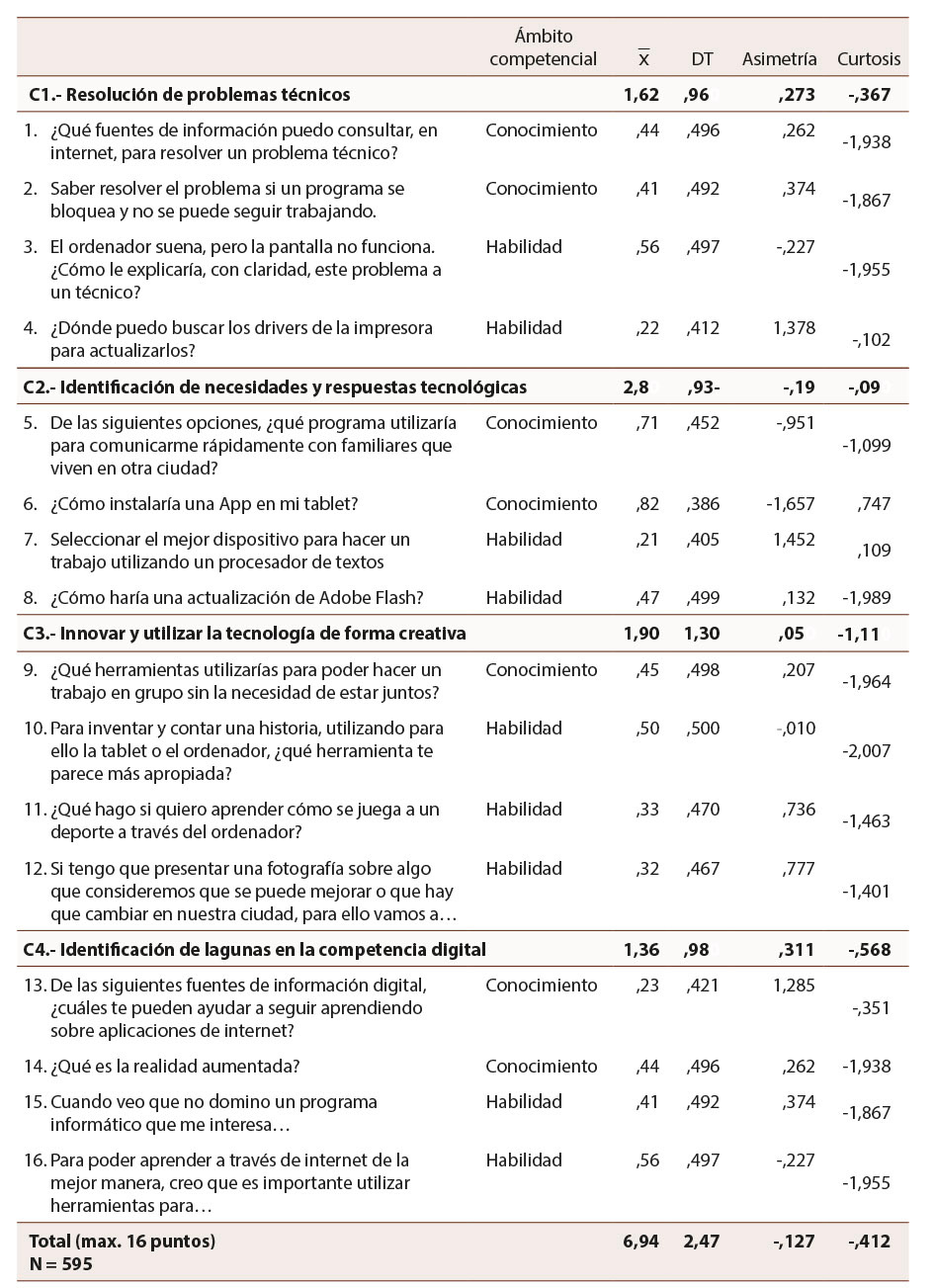

Para este análisis, los ítems han sido agrupados en cuatro competencias (C1 a C4) creadas a partir de la suma de las puntuaciones de los cuatro ítems que la miden. Se presentan los estadísticos de la media, la desviación típica, la asimetría y la curtosis, especificando, en cada uno de ellos, el ámbito competencial (conocimiento/habilidad) (Tabla 1). Como los ítems son dicotómicos (acierto 1/error 0) las valoraciones máximas obtenidas en la puntuación media son de 1.

Tabla 1: Análisis descriptivo de los ítems que componen la prueba

Nota: Elaboración propia.

Las puntuaciones medias oscilan entre 1,36 (C4) y 2,80 (C2). Así, el estudiantado tiene mayor conocimiento y capacidad sobre la identificación de necesidades y respuestas tecnológicas, en primer lugar, y sobre innovar y utilizar la tecnología de forma creativa, en segundo lugar, seguido de la resolución de problemas técnicos y la identificación de lagunas en la competencia digital.

La puntuación media total en la prueba completa es de 6,9 puntos sobre 16, aproximándose al punto central (8) de la escala. Teniendo en cuenta la puntuación media de cada uno de los ítems, la mínima es la del 7 (=0,21) y la máxima la del 6 (=0,82), lo que demuestra que existen diferencias en cuanto a su dificultad. El 7 lo aciertan un 21% del estudiantado, por lo que se considera el más difícil, y el 6 un 82%, el más fácil, lo que manifiesta que el alumnado no sabe seleccionar los mejores dispositivos para trabajar con un procesador de textos, pero sí saben instalar apps en una tablet.

Algunos de los ítems (4, 6, 7 y 13) presentan una asimetría elevada (> 1 o >-1). Respecto a la curtosis, todos presentan puntuaciones inferiores a 3 y en la mayoría de los casos negativas, por lo que pueden considerarse distribuciones platicúrticas. Estos valores por debajo de 0 también indican que los datos están muy dispersos.

Análisis preliminar: Índice de dificultad, discriminación, homogeneidad y fiabilidad

En relación con el índice de dificultad, la tasa promedio en los 16 ítems es del 43,43%, lo que confirma, empíricamente, una dificultad moderada del instrumento ya anticipada por las personas expertas. En relación con los ítems que evalúan capacidades, los aciertos constituyen un 43,31% y los que evalúan conocimientos un 43,55%. No se aprecian prácticamente diferencias entre ambos ámbitos competenciales, excepto si nos fijamos en el porcentaje de aciertos en función de las distintas subáreas. El estudiantado tiene mayor competencia en la de identificación de necesidades y respuestas tecnológicas (52,05%), y menor en la de identificación de lagunas en la competencia digital (34,15%) de las 4 subáreas.

No es una prueba demasiado equilibrada, ya que, aunque predominan las preguntas de nivel intermedio y estas son las que mejor discriminan, carece de las que se sitúan en las categorías extremas (muy fácil-muy difícil). También hay pocas en la de fácil y demasiadas en la de difícil. Los ítems muestran un nivel alto de pertinencia percibida, incluso con un ligero incremento en los de la sub-área identificación de lagunas en la competencia digital, lo que aconseja conservarlos para una posible versión futura del instrumento destinada a una población de mayor edad.

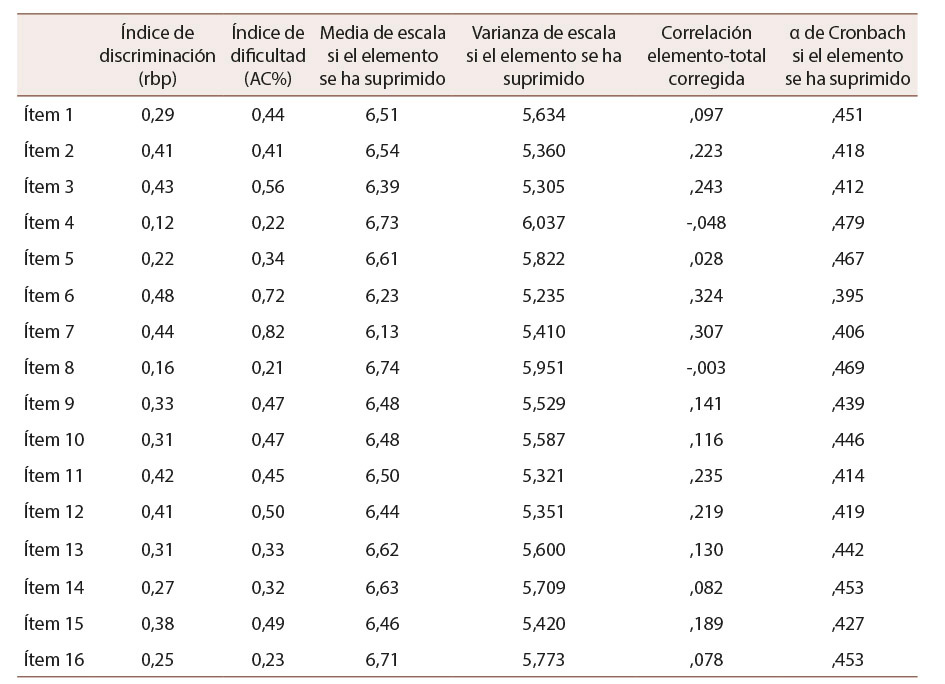

En la Tabla 2 se muestran los datos estadísticos de cada uno de los ítems de conocimiento y capacidad que permiten conocer su índice de discriminación (correlación biserial puntual), su índice de dificultad, la media y varianza de la escala si se suprimiera el ítem, la correlación de los elementos corregida y la fiabilidad de la escala si se suprimiera el ítem.

Tabla 2: Estadísticas de ítems de conocimiento y capacidad

Nota: Elaboración propia.

El análisis de cada uno de ellos y su aportación a la fiabilidad total de la prueba sugeriría suprimir aquellos ítems que si no estuvieran la aumentarían, como en el caso del 4 y del 8 (α de Cronbach = 0,48 en el primero y α de Cronbach = 0,47 en el segundo), que además arrojan una correlación negativa. Estos valores pueden considerarse poco aceptables (<0,70) aunque sería importante tener en cuenta las sugerencias de algunos estudios en relación con la aplicación del α de Cronbach al utilizar una escala dicotómica (Oliden y Zumbo, 2008; Zumbo et al., 2007).

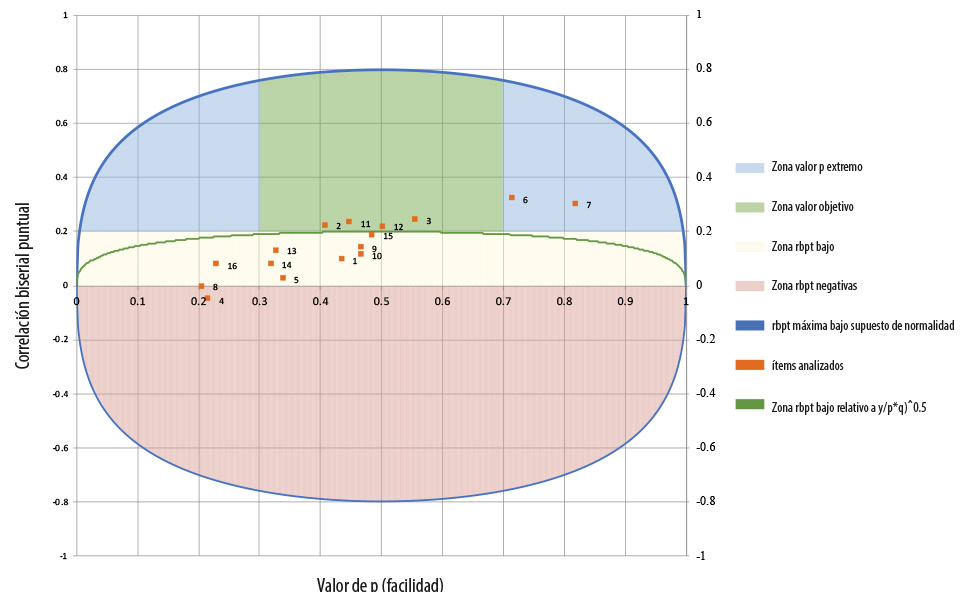

La Figura 1 representa, mediante ejes de coordenadas, los ítems de la prueba distribuidos teniendo en cuenta el índice de dificultad/facilidad y el de discriminación (correlación biselial puntual). En función de la zona en la que se sitúe el valor p se representa gráficamente la estructura de los ítems. Así, encontramos dos (6 y 7) en la azul, identificados con un nivel bajo de dificultad. Se justifican desde un punto de vista conceptual por tratarse de cuestiones básicas en la evaluación de la competencia digital, como: instalar una App en la tablet y saber seleccionar el mejor dispositivo para hacer un trabajo utilizando un procesador de textos. En la verde o zona objetivo, considerada como las más adecuada, se sitúan el 2, 3, 11 y 12, con un índice de dificultad media. La amarilla o rbpt, de mayor dificultad, no es la más apropiada y en ella se concentran la mayoría de los ítems (1, 5, 9, 10, 13, 14, 15, 16) que, sin embargo, pueden ser aceptados por sus índices de discriminación adecuados. Finalmente, el 4 y el 8 quedan al margen en la zona de discriminación negativa, y deben ser objeto de modificación o eliminación.

Figura 1: Distribución de los ítems en función de índices de dificultad y discriminación (rbp)

Nota: Elaboración propia.

Análisis correlacional

Para conocer las relaciones entre los 16 ítems se aplicó el estadístico de Pearson. Existen correlaciones positivas y negativas y en la mayoría de los casos no son elevadas, aunque sí significativas. Como casos excepcionales se señala el ítem 1 que no correlaciona con el resto y el 5 que lo hace únicamente con el 16.

Si nos centramos en las cuatro competencias se observan, dado el tamaño de la muestra, correlaciones con valores moderados, pero altamente significativos, a excepción de la C4 sobre identificación de lagunas en la competencia digital que no lo hace ni con la C3 (innovar y utilizar la tecnología de forma creativa), ni tampoco con las actitudinales.

Análisis de fiabilidad de la prueba de conocimientos y capacidades

Se calculó mediante el método Kuder Richardson (coeficiente de correlación KR20), teniendo en cuenta el carácter dicotómico de los 16 ítems. El valor obtenido (r20=0,45) demuestra un coeficiente de consistencia interna que puede considerarse pertinente para este tipo de instrumentos de evaluación de competencias, puesto que se trata ítems que no tienen la misma dificultad. Contrastada la hipótesis de significación, se pudo determinar que el valor alfa obtenido es poco significativo, ello indica que la prueba tiene una confiabilidad moderada-baja. Por tanto, este valor del coeficiente no es suficiente para garantizar la fiabilidad de la escala.

Análisis de los ítems de la escala de actitudes

Estadísticos descriptivos

La actitud es muy positiva, con una puntuación media en el total de la escala de 25,42 sobre 30. Si se tiene en cuenta cada uno de los ítems, la media es muy elevada en todos ellos, especialmente los mejor valorados son el 1 (Es importante conocer las características de dispositivos y aplicaciones) y el 6 (Es importante conocer las propias limitaciones en el uso de las tecnologías), ambos con una elevada asimetría (> 1 o >-1). Respecto a la curtosis, la mayoría presentan valores inferiores a 3, demuestra que los datos están muy dispersos y que las distribuciones son platicúrticas. Excepcionalmente en los ítems 1 y 6 se obtienen puntuaciones mayores que 3, considerándose una curtosis leptocúrtica que indica que existe una gran concentración de los valores sobre su media.

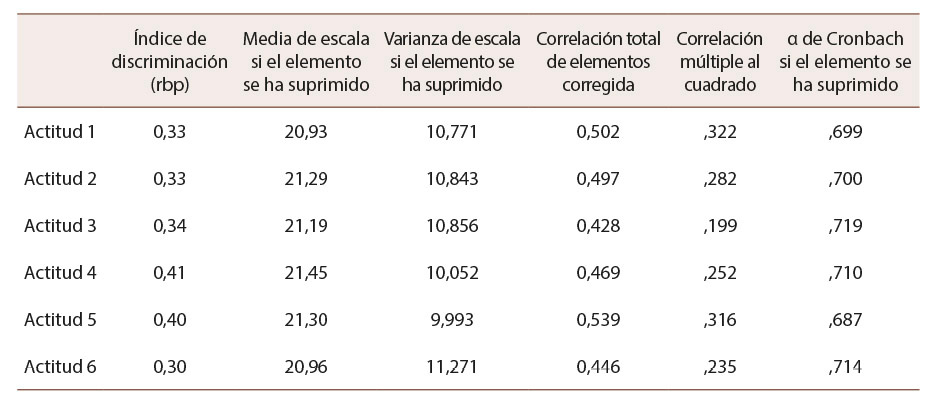

Análisis preliminar: Índice de discriminación y fiabilidad

El índice de discriminación se determina con la correlación biserial puntual, dicotomizando la variable. Las puntuaciones 4 y 5 se consideraron como “actitud positiva” y el resto de las puntuaciones (1, 2 y 3) como “actitud negativa”. Las correlaciones son positivas en todos los casos con un índice de discriminación adecuado (Tabla 3).

Tabla 3: Estadísticos de total de ítems de actitudes

Nota: Elaboración propia.

Calculado el α de Cronbach se obtuvo una puntuación de 0,78 lo que indica una fiabilidad muy aceptable, si se tiene en cuenta el reducido número de ítems.

Análisis correlacional

Calculado el coeficiente de Pearson, se observa que todos los ítems muestran correlaciones significativas con el resto y con el total de la escala. En el primero de los casos, las más altas se establecen entre los ítems 1, 4 (sobre dispositivos) y 5 (sobre tecnología que permite trabajar de forma colaborativa). Las mostradas con el total de la escala son las más elevadas al superar, en casi todos los casos, el valor de 0,60.

Análisis de la prueba completa

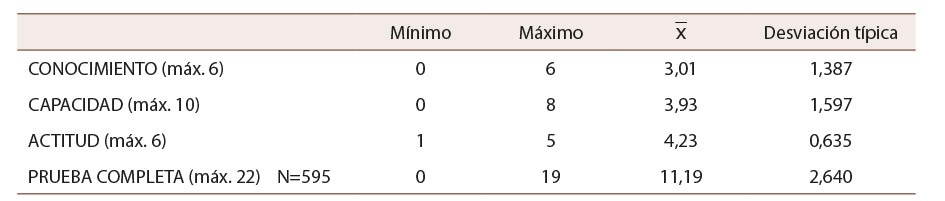

Estadísticos descriptivos

En general, las actitudes son mucho más positivas que las puntuaciones obtenidas en los ámbitos competenciales de conocimiento y capacidad (Tabla 4). En una escala de 0-22 puntos, la puntuación global es de 14, se situán los ámbitos competenciales próximos al punto medio, y alcanzan las actitudes un nivel alto (>4). La desviación típica del total de la prueba pone de manifiesto la variabilidad que se atribuye a la prueba, capaz de diferenciar entre los distintos niveles de competencia de los sujetos.

Tabla 4: Análisis descriptivo de los 3 ámbitos de las competencias

Nota: Elaboración propia.

Fiabilidad y validez

Para la prueba de conocimiento y capacidad (16 ítems dicotómicos), la fiabilidad se comprobó mediante el método Kuder Richardson (coeficiente de correlación KR20) se obtuvo un valor de r20= 0,45. Para la escala de actitudes (tipo Likert) se hizo mediante el α de Cronbach cuyo valor fue de 0,78.

Al considerar la prueba completa, un total de 22 ítems, se obtuvo un valor α de Cronbach de 0,65. Volvemos a recordar que la fiabilidad variaría si se eliminara el ítem 4 y 8, tal y como se sugirió con anterioridad, en cuyo caso la puntuación se situaría en 0,66.

Respecto a la validez, entendida como la capacidad que tiene una escala para medir, de manera adecuada y significativa, el factor o la dimensión para la que ha sido creada (Muñiz, 1998; Wiersma, 1986), se optó por realizar dos tipos: de contenido y de estructura.

En relación con la validez de contenido, los ítems de la prueba se ajustan a un prototipo de indicadores de la competencia digital que, fundamentado en el modelo DigComp, fue diseñado por el equipo de investigación y validado por personas expertas, como ya se indicó anteriormente (puede consultarse en https://gredos.usal.es/handle/10366/139409). Tomando como base este modelo de indicadores, ajustados todos ellos a las edades del estudiantado de educación obligatoria, se formularon los ítems de la prueba que fueron sometidos a juicio experto mediante la técnica de grupos de discusión, con lo que se consiguió una formulación final por medio de un riguroso proceso de discusión y debate de los enunciados y respuestas de los ítems. Todo este proceso sirvió para diseñar un conjunto de ítems con validez de contenido (siguiendo las pautas del modelo teórico-conceptual DigComp) que conforman la prueba del área competencial de resolución de problemas, válida para medir los conocimientos, capacidades y actitudes. El análisis de los ítems demostró su capacidad de discriminación y ajuste a la población de referencia, exceptuando el 4 y el 8 que, según los resultados obtenidos, debieran ser revisados para su posible reformulación o eliminación.

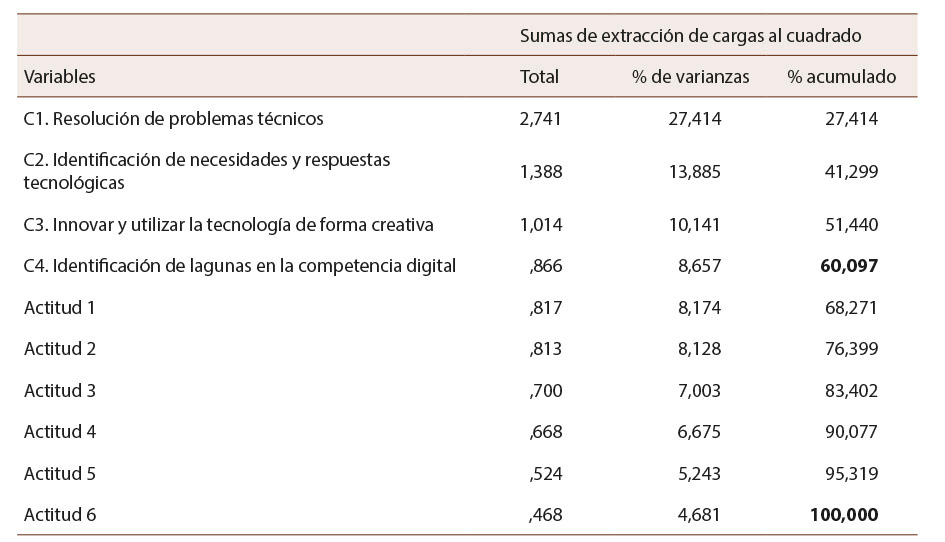

Para el estudio de la validez estructural, primeramente, se calculó el índice de adecuación muestral KMO y la prueba de esfericidad de Bartlett para la totalidad del instrumento. Los resultados obtenidos en la medida de KMO son aceptables por ser superiores a ,50 y la prueba de esfericidad de Barlett se considera altamente significativa (p<.001), con un valor de Chi-cuadrado de 802,688 y con 45 grados de libertad, lo cual indica que los datos se correlacionan positivamente, al mostrar una relación lineal entre las variables. Ello permitió realizar un análisis factorial mediante el estudio de componentes principales con el método de rotación varivax con normalización Kaiser, tomando como variables las 4 competencias de conocimiento-capacidad (C1-C4) y los 6 ítems de actitudes (Tabla 5). La técnica empleada fue la multivariante con el propósito de simplificar, en el menor número de elementos posible, un grupo de variables interrelacionadas en un grupo de factores independientes, para comprobar la correlación entre variables y poder realizar una reducción de los datos simplificando la estructura.

Tabla 5: Porcentaje de varianzas total explicada en cada variable

Nota: Elaboración propia.

En el análisis de componentes principales se calcularon los valores l para cada uno de los componentes reteniendo los factores cuyo valor l ≥ 1. El primer factor explica el 60,09% de la varianza y el segundo añade 39,90%, de modo que los dos explican el 100% de la varianza de la matriz factorial.

Tras realizar un análisis factorial exploratorio, forzando el número de factores a dos, se consigue alcanzar la unidimensionalidad con un 100% de varianza explicada y se confirma, en este sentido, la validez de la prueba. La variable C1 resolución de problemas técnicos explica el 27,41% de la varianza total, la C2 identificación de necesidades y respuestas tecnológicas el 13,88%, la C3 innovar y utilizar la tecnología de forma creativa el 10,14% y la C4 identificación de lagunas en la competencia digital el 8,65%. Finalmente, la variable de actitud (incluyendo los 6 ítems) explica un 39,9% de la varianza total, con un peso factorial muy alto en la totalidad de la escala.

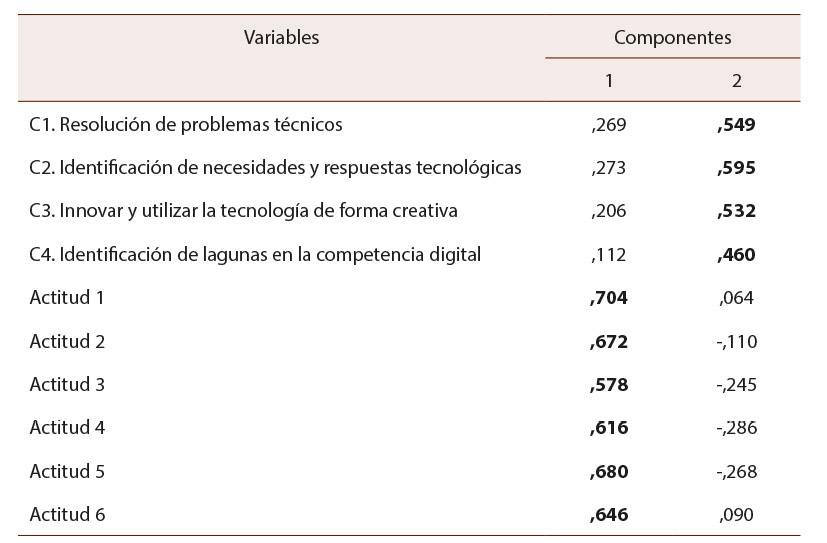

En la matriz de componentes (Tabla 6) se puede observar la saturación de los ítems de actitudes en el primer factor y de los de competencias sobre conocimientos/capacidades en el segundo factor.

Tabla 6: Matriz de componentes principales

Nota: Método de extracción: Análisis de componentes principales. Método de rotación: Varimax con normalización Kaiser.

Elaboración propia.

Todos los ítems adquieren el peso suficiente (<40) para ser ubicados en el mismo factor en el que los establecieron tanto el equipo investigador como el comité experto que validó el contenido de la prueba (Ferrando, 1996). Los correspondientes a la variable actitud presentan valores altos en la interpretación del factor, por lo que pueden considerarse determinantes.

Para finalizar este estudio de las características de la prueba se pretendió comprobar que los ítems no tenían sesgo en función del género, calculando los valores de Chi cuadrado. Los resultados evidencian que no hay diferencias significativas prácticamente en ninguno de los ítems a excepción del 9 (p= 0.02), con mayor número de aciertos en los chicos (52% frente al 42%).

Conclusiones y discusión

La evaluación de la competencia digital del estudiantado de educación obligatoria es una actividad importante, ya que sus resultados aportarán información relevante para diseñar y desarrollar propuestas de alfabetización tecnológica dentro del sistema educativo (Henriquez-Coronel et al., 2018).

Para ello, es necesario diseñar procesos de evaluación que superen la percepción que los sujetos tienen de sí mismos en relación con diferentes aspectos de la competencia digital, para identificar, realmente, los conocimientos, capacidades y actitudes que posee el alumnado (Frailon et al., 2013). En este sentido, se ha presentado una prueba válida y fiable que permite identificar el nivel de competencia digital del estudiantado al superar el sesgo presente en aquellos instrumentos utilizados en la evaluación como un proceso de medida de autovaloración centrado en el aspecto subjetivo de las respuestas de los sujetos participantes (González-Segura et al., 2018).

El área competencial que abarca este instrumento es el de resolución de problemas, evaluada por medido de cuatro competencias digitales: resolución de problemas técnicos, identificación de necesidades y respuestas tecnológicas, innovación y uso de la tecnología de forma creativa, e identificación de lagunas en la competencia digital. Las correlaciones entre estas mismas son significativas al 0,01, excepto entre innovar y utilizar la tecnología de forma creativa y la identificación de lagunas en la competencia digital (competencias 3 y 4), en las que no existe correlación significativa. El análisis factorial muestra dos factores diferenciados: el relacionado con los conocimientos y habilidades y el vinculado con las actitudes. El estudio de los ítems se realizó de forma diferenciada, considerando su tipología (prueba objetiva y escala Likert), por lo que se puede concluir que tienen un buen nivel de discriminación, aunque son poco equilibrados en el nivel de dificultad, con predominio de los ítems difíciles. Dos de ellos deben ser sometidos a revisión para modificarlos o eliminarlos, dada su excesiva dificultad y escasa discriminación.

La prueba se compone de preguntas y cuestiones de diferente nivel competencial:

• Básico: 2 ítems (fáciles; porcentaje > 61% de aciertos).

• Intermedio: 8 ítems (dificultad moderada; porcentajes entre 41%-60% de aciertos).

• Avanzado: 6 ítems (4 difíciles y 2 muy difíciles; porcentaje <40% de aciertos).

Una vez aplicada la prueba a una muestra de 595 escolares de educación obligatoria en 17 centros educativos, el nivel de competencia en resolución de problemas es básico (=11,19 en una escala de 0 a 22; DT=2,64). Las puntuaciones en las dimensiones de conocimiento y habilidad son más bajas que en la de actitud. En conocimientos se observa una puntuación = 3,01; DT=1,59 (escala de 0 a 6) y en capacidad encontramos una = 3,93; DT=2,11 (escala de 0 a 10); mientras que en actitudes se sitúa en una =4,23; DT=0,63 (escala de 0 a 6). Estos resultados coinciden con los de otros estudios que evalúan también áreas competenciales del modelo DigComp (Basilotta Gómez-Pablos et al., 2020; García-Valcárcel Muñoz-Repiso, Salvador Blanco et al., 2019; Rodríguez-Groba et al. 2021).

Respecto al género, los ítems de la prueba no presentan ningún sesgo, lo que permite concluir que el instrumento es válido para su aplicación en ambos colectivos.

Los resultados obtenidos en el estudio psicométrico de la prueba son similares al de otras investigaciones (Casillas-Martín y Cabezas González, 2020; Casillas-Martín et al., 2020; García-Valcárcel Muñoz-Repiso et al., 2020) que presentan instrumentos para la evaluación observada de la competencia digital, por medio de la ejecución de actividades o resolución de problemas, en el ámbito de la educación obligatoria.

Resultaría interesante y pertinente proponer otras estrategias complementarias de evaluación que permitan verificar, de manera práctica y por medio de actividades específicas, la competencia digital de este estudiantado.

Declaración de Material complementario

Este artículo tiene disponible, como material complementario:

-La versión preprint del artículo en https://doi.org/10.5281/zenodo.4041992

Referencias

Alonso-Ferreiro, A. y Gewerc, A. (2018). Alfabetización mediática en la escuela primaria. Estudio de caso en Galicia. Revista Complutense de Educación, 29(2), 407-422. https://doi.org/10.5209/RCED.52698

Baena Paz, G. (1985). Manual para elaborar trabajos de investigación documental. Editores Unidos Mexicanos.

Basilotta Gómez-Pablos, V., García-Valcárcel Muñoz-Repiso, A., Casillas Martín, S. y Cabezas González, M. (2020). Evaluación de competencias informacionales en escolares y estudio de algunas variables influyentes. Revista Complutense de Educación, 31(4), 517-528. https://doi.org/10.5209/rced.65835

Brooks-Young, S. (2016). ISTE standards for students. A practical guide for learning with yechnology. Stanstebook.

Cabezas González, M. y Casillas Martín, S. (2018). Social educators: A study of digital competence from a gender differences perspective. Croatian Journal of Education, 20(1), 11-42. https://doi.org/10.15516/cje.v20i1.2632

Calvani, A., Cartelli, A., Fini, A. y Ranieri, M. (2008). Models and instruments for assessing digital competence at school. Journal of e-Learning and Knowledge Society, 4(3), 183-193. http://citeseerx.ist.psu.edu/viewdoc/download?doi=10.1.1.830.3183&rep=rep1&type=pdf

Carretero, S., Vuorikari, R. y Punie, Y. (2017). DigComp 2.1. The digital competence framework for citizens. With eight proficiency levels and examples of use. Publications Office of the European Union. https://doi.org/10.2760/38842

Casillas-Martín, S. y Cabezas-González, M. (2020). Validación de la prueba de evaluación de competencias digitales para estudiantes de educación obligatoria (ECODIES). En A. Hernández Martín y A. Iglesias Rodríguez (Coords.), Evaluación de las competencias digitales de estudiantes de educación obligatoria. Diseño, validación y presentación de la prueba ECODIES (pp. 67-90). Octaedro.

Casillas-Martín, S., Cabezas-González, M. y García-Valcárcel, A. (2020). Análisis psicométrico de una prueba para evaluar la competencia digital de estudiantes de educación obligatoria. RELIEVE, 26(2), 1-22. http://doi.org/10.7203/relieve.26.2.17611

Castro Morera, M. (2011). ¿Qué sabemos de la medida de las competencias? Características y problemas psicométricos en la evaluación de competencias. Bordón, 63(1), 109-123. https://dialnet.unirioja.es/servlet/articulo?codigo=3601046

Ferrando, P. J. (1996). Evaluación de la unidimensionalidad de los ítems mediante análisis factorial. Psicothema, 8(2), 397-410. http://www.psicothema.com/pdf/38.pdf

Ferrari, A. (2013). DigComp: A framework for developing and understanding digital competence in Europe. European Union. https://doi.org/10.2788/52966

Frailon, J., Schulz, W., Friedman, T., Ainley, J. y Gebhardt, E. (2013). IEA international computer and information literacy Study. Secretariat. https://doi.org/10.15478/uuid:b9cdd888-6665-4e9f-a21e-61569845ed5b

García-Valcárcel Muñoz Repiso, A., Hernández Martín, A., Mena Marcos, J. J., Iglesias Rodríguez, A., Casillas Martín, S., Cabezas González, M., González Rodero, L., Martín del Pozo, M. y Basilotta Gómez-Pablos, V. (2019). Modelo de indicadores para evaluar la competencia digital de los estudiantes tomando como referencia el modelo DigComp (INCODIES). https://gredos.usal.es/jspui/handle/10366/139409

García-Valcárcel Muñoz-Repiso, A., Salvador Blanco, L., Casillas-Martín, S. y Basilotta Gómez-Pablos, V. (2019). Evaluación de las competencias digitales sobre seguridad de los estudiantes de educación básica. RED, Revista de Educación a Distancia, 19(61), 1-34. https://doi.org/10.6018/red/61/05

García-Valcárcel Muñoz-Repiso, A., Casillas Martín, S. y Basilotta Gómez-Pablos, V. (2020). Validation of an indicator model (INCODIES) for assessing student digital competence in basic education. Journal of New Approaches in Educational Research, 9(1), 110-125. https://doi.org/10.7821/naer.2020.1.459

González-Segura, C. M., García-García, M. y Menéndez-Domínguez, V. H. (2018). Análisis de la evaluación de competencias y su aplicación en un sistema de gestión del aprendizaje. Un caso de estudio. RED. Revista de Educación a Distancia, 17(58), 1-20. http://dx.doi.org/10.6018/red/58/3

Henriquez-Coronel, P., Gisbert Cervera, M. y Fernández Fernández, I. (2018). La evaluación de la competencia digital de los estudiantes: Una revisión al caso latinoamericano. Chasqui. Revista Latinoamericana de Comunicación, (137), 93-112. https://dialnet.unirioja.es/servlet/articulo?codigo=6578583

ISTE. (2008). ISTE Standards for Teachers. NETBO2.

Krumsvik, R. J. (2011). Digital competence in Norwegian teacher education and schools. Högre Utbildning, 1(1), 39-51. https://www.researchgate.net/publication/305360830_Digital_competence_in_the_Norwegian_teacher_education

Mishra, P. y Koehler, M. (2006). Technological pedagogical content knowledge: A framework for teacher knowledge. State University. https://doi.org/10.1111/j.1467-9620.2006.00684.x

Muñiz, J. (1998). Teoría clásica de los test. Pirámide.

Oliden, P. E. y Zumbo, B. D. (2008). Coeficientes de fiabilidad para escalas de respuesta categórica ordenada. Psicothema, 20(4), 896‐901. http://www.psicothema.com/psicothema.asp?id=3572

Rodríguez-Groba, A., Martínez-Piñeiro, E. y González-Villa, Á. (2021). Lights and shadows in the e-communication of Galician pre-teens. IEEE Revista Iberoamericana de Tecnologias del Aprendizaje, 16(1), 122-131. https://doi.org/10.1109/RITA.2021.3052675

Serafín, Č., Depešov, J. y Bánesz, G. (2019). Understanding digital competences of teachers in Czech Republic. European Journal of Science and Theology, 15(1), 125-132. https://www.researchgate.net/publication/330262611_Understanding_digital_competences_of_teachers_in_Czech_Republic

United Nations Educational, Scientific and Cultural Organization. (2011). UNESCO ICT competency framework for teachers. Autor. https://unesdoc.unesco.org/ark:/48223/pf0000213475

Vuorikari, R., Punie, Y., Carretero, S y van den Brande, L. (2016). DigComp 2.0: The digital competence framework for citizens. Update phase 1: The conceptual reference model. Publication Office of the European Union. https://doi.org/10.2791/11517

Wiersma, W. (1986). Research methods in education: An introduction. Allyn and Bacon.

Zumbo, B. D., Gadermann, A. M. y Zeisser, C. (2007). Ordinal versions of coefficients alpha and theta for Likert rating scales. Journal of Modern Aapplied Statistical Methods, 6(1), 20-29. https://doi.org/10.22237/jmasm/1177992180

Artículo de la Revista Electrónica Educare de la Universidad Nacional, Costa Rica by Universidad Nacional is licensed under a Creative Commons Attribution-NonCommercial-NoDerivs 3.0 Costa Rica License.

Based on a work at https://www.revistas.una.ac.cr/index.php/EDUCARE

Permissions beyond the scope of this license may be available at educare@una.ac.cr